👁🗨👨🤖 El test de Turing y la inteligencia de las máquinas (parte II)

Por Enio...

La vez pasada estuvimos hablando sobre los pormenores del Test de Turing, que es el nombre moderno dado a un experimento que ideó el científico pionero de la computación Alan Turing a mediados del siglo pasado y que dio a conocer en el artículo académico denominado Computer Machine and Intelligence (Maquinaria computacional e inteligencia), el cual en este 2020 cumple unos 70 años de publicado pero cuyos problemas planteados aún siguen vigentes.

Dijimos que el experimento propuesto consiste en medir el éxito que puede alcanzar un ente artificial (llámese máquina, computadora o programa) en un juego propio de los seres humanos, donde el indicador de éxito es demostrar el mismo rendimiento que un jugador humano.

Pero tal juego no es uno cualquiera, pues las computadoras nos igualan y ganan en multiplicidad de juegos, sino uno muy específico que Turing llamó 'Juego de imitación'. Su dificultad para el ente artificial radica en que este último debe usar un lenguaje natural y con él exhibir un comportamiento inteligente que los humanos atribuyen única e inconfundiblemente a otro ser humano. De allí lo de 'imitación'.

La idea tras la medición es saber si un ente artificial ha adquirido la cualidad de pensante, esto es, que puede pensar, por lo que en principio el test de Turing provee un método para investigar si las computadoras-máquinas-programas pueden a su manera implementar procesos intelectuales equiparables al pensamiento humano. Se trata de un tema de interés y especie de 'Santo Grial' dentro de la disciplina de Inteligencia artificial.

⬆️ Imagen 1: Alan Turing, matemático, científico pionero de la computación, critógrafo y filósofo británico

También comentamos algunos casos de programas chatbots que han sido relativamente exitosos en lo que se refiere a exhibir algunos comportamientos inteligentes que los seres humanos adjudican a otros seres humanos, y que algunos chatbots (como Eugene Goostman) sí han logrado "pasar" el test de Turing, pero no de una manera que goza de la aceptación y aclamación consensuada de la comunidad científica. La razón: todos los casos exhiben la apariencia de pensar, pero realmente no se trata de entidades artificiales que pueden pensar.

De allí que, tras todo ello, haya sido inevitable preguntarse: ¿será entonces que el test de Turing puede tratar solamente con las apariencias en vez de procesos intelectuales auténticos? ¿Se tratará de un defecto del propio test? ¿No será más bien que las computadoras jamás podrán llegar a pensar y ser tan inteligentes como los humanos? Si es así, ¿existen obstáculos concluyentes que lo impidan?

Entre defectos, apariencias, objeciones y obstáculos, la verdad es que hay señalamientos razonables y merecen ser respondidos. Turing, de hecho, dedica una parte de su prenombrado ensayo a responder a varias objeciones a las ideas tras su experimento, algunas de las cuales ya databan desde su época, mientras que otras él imaginó podrían tornarse más serias en el futuro. Y estuvo en lo cierto: con el pasar de los años se han revitalizado algunas objeciones y han surgido observaciones críticas al test de Turing y al proyecto de computadoras pensantes.

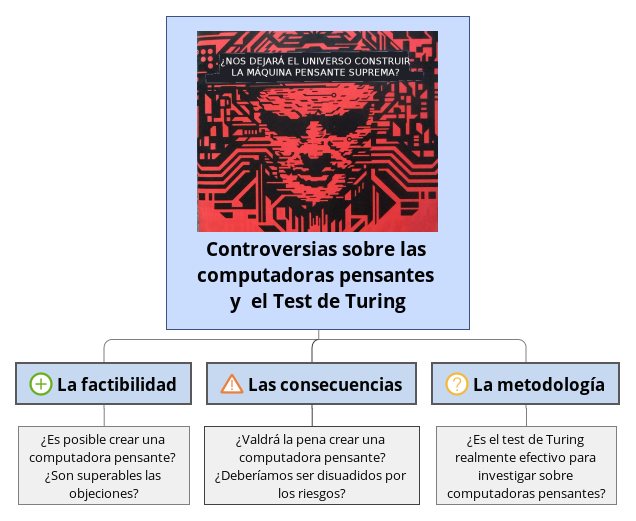

A continuación comentaré algunas implicaciones controversiales del test de Turing que forman parte del debate inaugurado por el mismo dentro del área de la inteligencia artificial e incluso más allá. Propongo discutir las que personalmente me parecen más interesantes, para lo cual también ofrezco mis propias opiniones. Aunadamente propongo organizarlas y presentarlas en tres categorías: controversias sobre la factibilidad, controversias sobre las consecuencias y controversias sobre la metodología. El siguiente esquema servirá de ayuda.

⬆️ Imagen 2: Categorías de las implicaciones controversiales que abordaremos.

Controversias sobre la factibilidad

Aquí se agrupan a las objeciones a la posibilidad real de desarrollar una inteligencia artificial fuerte. Sabemos que esta se refiere a aquella inteligencia de origen no biológico que sea tan alta como la del ser humano o incluso superior, en cuyo caso la llamaríamos también superinteligencia. Debemos aclarar que para cuando Turing abordó el asunto, el término inteligencia artificial no se había acuñado aún, por lo que él hablaba más bien de "máquinas pensantes". Cuando aquí hablamos de computadoras pensantes e inteligencia artificial fuerte, estamos básicamente haciendo alusión a lo mismo.

Ahora bien, ¿será teóricamente válido, físicamente posible y tecnológicamente viable crear un ente artificial que posea tal nivel de inteligencia igual o mayor al del ser humano? Mientras los investigadores trabajan en incrementar nuestro conocimiento al respecto, se escuchan buenos argumentos lógicos a favor y en contra de esa idea, pero la ciencia no tiene una respuesta definitiva aún. Pienso que dar con una respuesta positiva a estas preguntas supone superar distintas barreras en el problema de investigación: la barrera teórica, la barrera física y la barrera técnológica o de ingeniería.

Pero echemos un vistazo a los argumentos a favor de la respuesta negativa que son varios e interesantes.

Desentrañar la consciencia: ¿requisito previo?

Uno de los focos de controversias en este tema tiene que ver con la capacidad de consciencia, esa que nos permite tener sentido de identidad, reconocer lo que ocurre en nuestro entorno y sentir nuestra propia existencia. Muchos otros animales han adquirido esta capacidad, pero en el ser humano destaca considerablemente.

¿Deben ser las computadoras ser conscientes de su existencia para alcanzar un alto grado de inteligencia? Es algo que suele ser alegado y a menudo de una manera algo romántica, es decir, argumentada desde los sentimientos. Por ejemplo, en la primera mitad del siglo XX se escuchó el siguiente argumento en boca del neurólogo británico Geoffrey Jefferson a quien Turing cita diciendo:

Hasta que una máquina pueda escribir un soneto o componer un concierto debido a las emociones y pensamientos que tuvo, y que no sea debido al uso de símbolos al azar, podremos estar de acuerdo que máquina es igual a cerebro, es decir, no sólo que lo escriba, sino saber que lo escribió. Ningún mecanismo podría sentir (y no sólo una mera señal artificial, cosa fácil de hacer) placer por sus éxitos, sentir pesar cuando se le funde una válvula, sentirse bien con un halago, sentirse miserable por sus errores, estar encantado por el sexo, estar enojado o deprimido cuando no consigue lo que quiere

Se trata de una opinión bastante común incluso en nuestros días, compartida por muchas personas que quieren opinar en el tema, desde las muy educadas hasta las poco educadas, y es bastante impulsada por el sentido común, pues cuesta creer que las máquinas puedan desarrollar y demostrar sensibilidad y demás cualidades que posee un ser humano. La consciencia es una experiencia interna que los seres humanos sentimos especial en sobremanera.

Turing sin rodeos califica a esta posición de 'solipsista', esto es, la creencia filosófica de que los seres conscientes solo pueden estar seguros de su propia consciencia, no de la consciencia de los demás, por lo que no podría utilizarse en contra de probar la consciencia de las máquinas. Turing la considera una postura extremista si se alega como obstáculo, y al juzgar por los comentarios del Dr. Jefferson parece una interpretación razonable. También considera que en lugar de adoptar una posición así, es mejor no obstaculizar la investigación sobre máquinas pensantes utilizando su prueba como base.

Sin embargo, viendo los comentarios como los del profesor Jefferson mayormente como un recurso retórico y haciendo a un lado la recriminación de solipsismo, la pregunta sigue siendo válida: ¿Deben ser las computadoras conscientes de su existencia para alcanzar un alto grado de inteligencia?

No me propongo aquí definir ambos conceptos, pero es seguro decir que ambos fenómenos están bastante relacionados, pues sabemos que los daños fisiológicos en el cerebro pueden afectar tanto la consciencia como las capacidades intelectuales de un individuo. Esto también nos sugiere en principio que aún cuando la constitución de ambos procesos parte de una complicadísima y exquisita organización de la materia, todavía se tratan de fenómenos físicos, por lo que son estudiables y quizá hasta replicables en el laboratorio.

Empero, esa última afirmación es peligrosa, pues existe un debate alrededor de la naturaleza y el origen de la conciencia todavía más arduo que el debate de la inteligencia artificial, donde tenemos ideas fisicalistas (las que afirman que solo lo físico es real), algunas de las cuales son mutuamente excluyentes, e ideas dualistas (las que afirman que la consciencia transciende lo físico). Esta disyuntiva básicamente nos dice que la ciencia aún no ha descifrado el misterio de la consciencia y, por tanto, no tenemos respuesta a la pregunta formulada.

⬆️ Imagen 3: Aspectos comunes en los modelos de la mente ¿Debemos replicar todo esto para poder crear un ente artificial consciente?

Uno de los destacados científicos que actualmente argumenta en contra de la factibilidad de computadoras conscientes es el físico teórico Roger Penrose. Él ha teorizado que la conciencia se origina a nivel cuántico dentro dentro de las neuronas, y no a partir de los procesos entre ellas; una hipótesis que él llama Reducción objetiva orquestada. De ser cierta, esta añadiría una capa adicional de impedimentos al proyecto de computadoras pensantes en la medida como exista una conexión entre consciencia y pensamiento.

Otros estudiosos como David Wallace, por su parte, opinan que aunque la intuición puede hacernos pensar que consciencia es especial y requiere explicaciones especiales, no necesariamente debe ser cierto, de la misma manera como no necesitamos una teoría física fundamental para explicar la digestión o la respiración. La consciencia podría ser perfectamente generada a nivel de la actividad neuronal, por lo que los físicos no necesitarían resolver el problema, sino los biólogos y los neurólogos.

En la época de Turing, cuando este debate no era aún tan acalorado, reconociendo las paradojas y dificultades del problema, Turing se decantó por considerar prescindible resolver el misterio de la consciencia para poder saber si las computadoras podrán pensar. Actualmente, sin embargo, no estamos tan seguros de coincidir con él, pero eso no nos hace menos optimistas. Tendremos que esperar más investigación para entender más la conexión de la capacidad de conciencia con la inteligencia artificial.

Las matemáticas tienen algo qué decir

Otro de los argumentos interesantes para mí en contra de la factibilidad de computadoras pensantes es la objeción matemática, la cual Turing ya había considerado en su época, pero que años más tarde ha sido reimpulsada. ¿Qué palabra pueden tener las matemáticas al respecto? Mucha, pues la teoría de la computación pertenece a la rama de las matemáticas (sobre todo las discretas) y está construida sobre modelos formales, tales como los que el mismo Turing formuló para fundamentar las ciencias de la computación.

Según la objeción matemática, la lógica computacional tiene claros límites y ello está bien establecido por los Teoremas de la incompletitud de Gödel (1931) y el Problema de la parada de Turing (1937) los cuales responden la incógnita de probar la consistencia, completitud y decidibilidad de las matemáticas siguiendo un procedimiento general. Estos teoremas muestran que existe un conjunto de problemas lógicos que no pueden resolverse de manera algorítmica, la cual resulta ser la mismísima esencia de la computación.

No hay una forma sencilla de ejemplificar esto, pues estamos hablando de sistemas bastante formales, pero la idea fundamental es que al intentar resolver una así-llamada oración de Gödel, el programa de inteligencia artificial podría entrar en un bucle cuyo número de iteraciones puede ser ingente o infinito, por lo que el programa podría no detenerse nunca ni producir una respuesta. En otras palabras, el programa que simule el pensamiento podría ser saboteado, 'colgado' y delatado al enfrentarlo a cierta clase de problemas lógicos.

Esto tiene dos implicaciones: por una parte, la posibilidad de delatar al programa tendría sentido en el contexto del juego de imitación, donde el juez podría plantearle a los participantes un problema lógico donde se supone que las máquinas deben fallar. En realidad, el programa podría contar con un mecanismo para evitar resolver el problema lógico, de la misma manera como el participante humano muy probablemente hará, pues el problema lógico aludido es un asunto extremadamente formal y técnico, y no cualquier ser humano tiene el conocimiento y habilidades necesarios para resolverlo.

Sin embargo, la segunda implicación es que, en teoría, el programa siempre será incapaz de vencer a la persona en el problema lógico, lo cual da por sentado que no tendrá la misma capacidad intelectual de un ser humano, revelando al menos que las computadoras que simulen el pensamiento jamás podrán igualarnos.

Peor aún, en años más recientes se sugiere que, a diferencia de los seres humanos, el ente artificial ni siquiera podría simular el pensamiento, debido a que la mecánica de este último es sensiblemente diferente a la manera como operan las computadoras. En esencia, según este argumento se tiene que:

- La capacidad de pensar no puede ser algorítmica.

- El funcionamiento de un ente computacional inteligente es necesariamente algorítmico.

- Los humanos pueden pensar.

Siendo esto así, la primera conclusión lógica es que el ente artificial, al requerir de la implementación de un algoritmo, estaría gobernado por los principios de la lógica computacional y, por tanto, tendría limitaciones insalvables que no le permitirían alcanzar un nivel de inteligencia necesario para pensar. A su vez, con la premisa tres se puede concluir que los seres humanos sí pueden pensar porque la naturaleza de su pensamiento no es algorítmica y escapa de las limitaciones de la computación.

Este razonamiento se conoce como la Restricción Lucas-Penrose y si se prueba verdadero, calificaría como barrera teórica, ya que sería teóricamente imposible construir una inteligencia artificial basada en la máquinas computacionales y de estado discretos.

En el caso de Penrose, como ya mencionamos, también ha señalado, con su propuesta de la reducción objetiva orquestada, posibles limitaciones de la computación para alcanzar o simular la consciencia.

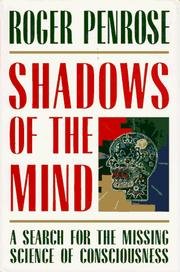

⬆️ Imagen 4: Las sombras de la mente. Uno de los trabajos de Roger Penrose donde debate la incomputabilidad de la consciencia.

La buena noticia para los investigadores de la inteligencia artificial es que tanto la reducción objetiva orquestada como la restricción Lucas-Penrose tampoco han sido demostradas científicamente en su totalidad, por lo que siguen siendo solo modelos teóricos y argumentos lógicos. En particular no se sabe si los seres humanos de veras escapamos de la restricción Lucas-Penrose, y lo mismo opinó Alan Turing hace 70 años cuando respondió a la objeción matemática. Dijo:

Aunque se establece que hay limitaciones para el poder de cualquier máquina, solo se ha dicho, sin ningún tipo de prueba, que tales limitaciones no se aplican al intelecto humano.

Sin embargo, de todas las objeciones existentes esta puede ser de las más serias y por eso Turing también reconoce: "No creo que esta visión pueda ser descartada a la ligera". Seguiremos a la expectativa.

¿Qué otras objeciones se tienen en contra de la factibilidad de desarrollar una inteligencia artificial fuerte? ¿Y qué hay de las objeciones metodológicas al test de Turing? Estaremos cubriéndolo en un próximo artículo.

Controversias sobre las consecuencias

Nos referimos a las consecuencias para la humanidad que tendría el éxito de esta línea de investigación con la materialización de entes artificiales con consciencia y capacidad de pensar. En realidad, esto tiene que ver más con la inteligencia artificial per se que con el propio test de Turing, pero tomar cuenta las posibles consecuencias (positivas o negativas) es una forma de promover desalentar las propuestas científicas al respecto. Además, el asunto tiene que ver con algo que el mismo Turing respondió.

En el caso de que tengamos éxito en esta ambiciosa empresa, más allá de la hipotética utilidad que una tecnología así podría otorgar a la sociedad, en el fondo podríamos pensarlo más bien como un hito y logro supremo del ser humano, ya que habríamos creado algo que va más allá de nuestras capacidades y que podría existir y evolucionar de manera autónoma. Incluso, puede que en el proceso hayamos respondido, entre otras cosas, a preguntas profundas sobre los secretos de la consciencia y la vida inteligente.

No obstante, no se puede jugar a ser dios sin ser comparado con el diablo, como diría un personaje científico de origen cinematográfico. En otras palabras, si todo fuese color de rosa, no existirían las controversias, por lo que seguramente hay ideas detractoras.

La más común de ellas seguramente es la idea de que la inteligencia artificial representa más bien una amenaza existencial para nuestra especie. Esto se ha tornado, de hecho, en un motivo artístico magistralmente explotado en la ciencia ficción durante un largo rato. Desde algunas novelas de Isaac Asimov hasta la saga de Terminator, a menudo se retratan a las máquinas rebelándose, subyugándonos y exterminándonos.

Dejando la ficción a un lado, no es menos cierto que en este milenio hemos comenzado a escuchar voces serias y reconocidas alertándonos sobre un peligro potencial parecido. Stephen Hawking y Elon Musk, por ejemplo, han expresado públicamente su recelo hacia la inteligencia artificial fuerte y que definitivamente debemos asegurarnos de hacer las cosas bien. Se sugiere que, una vez llegado a cierto punto, los humanos deberíamos adoptar medidas de precaución para no perder el control, además de regular la investigación y el progreso en este campo.

Es curioso que hace unos 70 años Turing vaticinó que "en algún momento cabría esperar que las máquinas tomen el control". Aunque eso no tiene porqué interpretarse de una manera apocalíptica como se hace actualmente en entornos extraacadémicos, sí tiene bastante similitud con una objeción que sí abordó más detenidamente en su ensayo y que llamó "cabezas en la arena".

Esta objeción dice que las computadoras pensantes constituirían una amenaza para la supremacía del ser humano, específicamente hacia su supremacía intelectual y al poder conseguido con ella, por lo que sería mejor no investigar ni pensar en desarrollar este tipo de tecnología; es mejor meter la cabeza en la arena y no ver... como el avestruz.

Para Turing, ese argumento tiene mayormente influencia en los intelectuales, pues valoran mucho la capacidad de pensar, y considera que esa objeción es más una preocupación vanidosa que una preocupación sincera por la conservación de la especie, por lo que rápidamente la desprecia: "no tiene sustancia", "no requiere refutación", dice.

No obstante, si vemos la objeción como un asunto de supervivencia, ciertamente puede ser razonable el que no queramos convivir con seres tan o más inteligentes que nosotros. Una de las teorías para explicar la extinción del Homo neanderthalensis (hombre de Neandertal) recoge precisamente la premisa de que las capacidades cognitivas del Homo sapiens (nosotros) eran más altas, lo cual le habría otorgado a este último mayores ventajas competitivas y contribuido ultimadamente a la extinción de aquellos cercanos parientes.

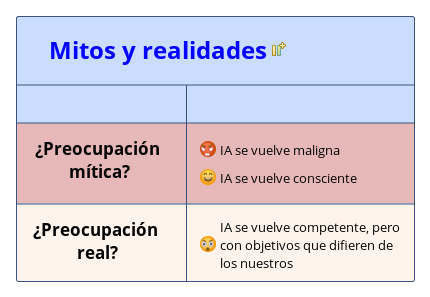

Se trata de una preocupación no descabellada que ya se ha sugerido en distintos entornos científicos, alegada incluso en el hipotético caso de hacer contacto con civilizaciones extraterrestres altamente inteligentes. Sin embargo, pasar de allí al temor basado en mitos es una historia diferente. Los expertos en inteligencia artificial actuales están preocupados no por la malignidad ética de la inteligencia artificial fuerte, sino por la posibilidad de que su aptitud o competencia esté desarticulada de nuestros objetivos.

⬆️ Imagen 5: ¿Es la amenaza de la inteligencia artificial un mito o una realidad?

De la misma manera como los seres humanos podemos cohabitar con muchas otras especies menos inteligentes porque estas no obstaculizan nuestros objetivos, se espera que la inteligencia artificial fuerte tenga objetivos donde nosotros no seamos una disonancia. Sin embargo, la implicación ética de ese punto de vista es también bastante controversial. Sea como sea, la verdad es que el asunto del peligro o utilidad asociados a la inteligencia artificial fuerte conlleva un debate de varios matices el cual no acaba aquí, pero que recoge algunas ideas detractoras que no impresionaron a Turing.

¿Y qué hay en cuanto a la metodología? ¿Es el test de Turing realmente efectivo para determinar si una computadora está pensando? En la próxima entrega continuaremos la discusión de estas controversias.

ALGUNAS REFERENCIAS

- Turing, A. M. (1950) Computing Machinery and Intelligence. Mind 49: 433-460. Versión en inglés Versión en español

- Saygin, Cicekli y Akman (2000) El test de Turing: 50 años después. Minds and Machines: 463–518. Artículo en inglés aquí

- Lucas J. R (1959) Mentes, máquinas y Gödel. Philosophy XXXVI: 112-127. Versión en inglés

- Penrose R. (1989) Las sombras de la mente: hacia una comprensión científica de la consciencia. Oxford University Press. ISBN 978-0-19-853978-0.. Versión en inglés

servidor de DiscordSi estás interesado en más temas sobre Ciencia, Tecnología, Ingeniería y Matemáticas (STEM, siglas en inglés), consulta las etiquetas #STEM-Espanol y #STEMSocial, donde puedes encontrar más contenido de calidad y también hacer tus aportes. Puedes unirte al de STEM-Espanol para participar aún más en nuestra comunidad y consultar los reportes semanales publicados por @STEM-Espanol.

NOTAS ACLARATORIAS

- La imagen 1 es de Mike McBey y de licencia CC BY SA 3.0. Fuente

- La imagen 4 es de los repositorios de Wikimedia commons. Fuente

- A menos que se indique lo contrario, las imágenes son del autor, algunas compuestas con la ayuda de imágenes dominio público.

Thanks for your contribution to the STEMsocial community. Feel free to join us on discord to get to know the rest of us!

Please consider supporting our funding proposal, approving our witness (@stem.witness) or delegating to the @stemsocial account (for some ROI).

Thanks for using the STEMsocial app

and including @stemsocial as a beneficiary, which give you stronger support.

Thank you!

Hola @eniolw.

Un artículo muy completo y robusto que nos puede proporcionar una fuente de análisis para abordar la frontera entre la inteligencia humana impregnada y llevada a las máquinas y la llamada inteligencia artificial.

Gracias por compartir esta importante pieza analítica. Saludos amigo @eniolw.

Me alegra le haya gustado, estimado @carlos84. Saludos!

Me pareció extraordinaria la selección realizada con respecto a las implicaciones controversiales del test de Turing las cuales compartes en tres categorías tales como: controversias sobre la factibilidad, controversias sobre las consecuencias y controversias sobre la metodología, de esta manera nos permites tener una mejor percepción sobre el desarrollo de la inteligencia artificial fuerte desde la mirada del test de Turing.

Mucha tela que cortar al respecto a estas controversias como muy bien expresas, estaré atento a tu próxima entrega para seguir obteniendo conocimiento del test de Turing y la inteligencia de las máquinas que como sabemos representa desde hace mucho tiempo un gran e interesante debate, gracias por compartir tus excelentes conocimientos con nosotros amigo Mentor. Éxitos.

Saludos amigo mentor @eniolw como de costumbre una excelente entrega relacionada al test de Turing y la inteligencia de las máquinas en su segunda parte.Fortificante comentario, @rbalzan79, gracias. Éxito para usted igualmente!